循环神经网络(RNN)是一类人工神经网络,节点之间的连接沿着时间序列形成一个有向图。这使它能够表现出时间上的动态行为。从前馈神经网络衍生出来的RNN可以利用其内部状态(记忆)来处理输入的可变长度序列。这使得它们适用于非分割、连接的手写识别或语音识别等任务。

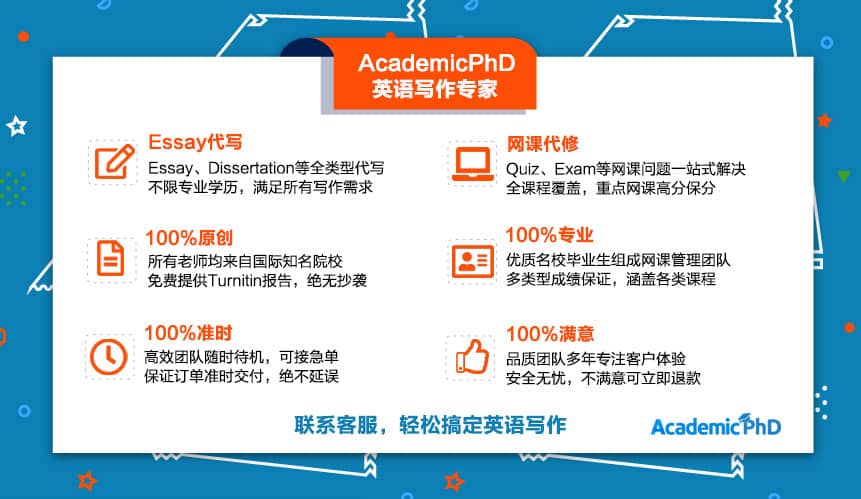

作为专业的留学生服务机构,AcademicPhD多年来已为美国、英国、加拿大、澳洲等留学热门地的学生提供专业的学术服务,包括但不限于Essay代写,Assignment代写,Dissertation代写,Report代写,小组作业代写,Proposal代写,Paper代写,Presentation代写,计算机作业代写,论文修改和润色,网课考试管理等等。写作范围涵盖高中,本科,研究生等海外留学全阶段,辐射金融,经济学,会计学,审计学,管理学等全球99%专业科目。写作团队既有专业英语母语作者,也有海外名校硕博留学生,每位写作老师都拥有过硬的语言能力,专业的学科背景和学术写作经验。我们承诺100%原创,100%专业,100%准时,100%满意。

递归神经网络代写Recurrent Neural Networks

术语 “递归神经网络 “被不加区分地用来指代两大类具有类似一般结构的网络,其中一类是有限脉冲的,另一类是无限脉冲的。这两类网络都表现出时间上的动态行为。有限脉冲递归网络是一个有向无环图,可以展开并替换成严格的前馈神经网络,而无限脉冲递归网络是一个有向循环图,不能展开。

有限冲动和无限冲动递归网络都可以有额外的存储状态,并且存储可以由神经网络直接控制。存储也可以由另一个网络或图代替,如果它包含时间延迟或有反馈回路的话。这种受控状态被称为门控状态或门控记忆,是长短期记忆网络(LSTM)和门控递归单元的一部分。这也被称为反馈神经网络(FNN)。

循环神经网络是基于David Rumelhart在1986年的工作。Hopfield网络–一种特殊的RNN–是由John Hopfield在1982年发现。1993年,一个神经历史压缩系统解决了一个 “非常深度学习 “的任务,该任务需要在一个RNN中展开超过1000个后续层。

长短时记忆(LSTM)网络是由Hochreiter和Schmidhuber在1997年发明的,并在多个应用领域创造了准确性记录。

2007年左右,LSTM开始彻底改变语音识别,在某些语音应用中超过了传统模型。2009年,一个经过连接主义时间分类(CTC)训练的LSTM网络是第一个赢得模式识别比赛的RNN,当时它在连接手写识别的几个比赛中获胜。2014年,中国公司百度使用CTC训练的RNN打破了2S09 Switchboard Hub5’00语音识别数据集的基准,没有使用任何传统语音处理方法。

LSTM还改善了大词汇量语音识别和文本到语音合成,并被用于谷歌Android。据报道,2015年,谷歌的语音识别通过CTC训练的LSTM,性能大幅跃升49%。

LSTM打破了改进机器翻译的记录,语言建模和多语种语言处理。LSTM与卷积神经网络(CNN)相结合,改进了自动图像字幕。

RNNs的行为可能是混乱的。在这种情况下,可以使用动力系统理论进行分析。

它们实际上是具有特殊结构的递归神经网络:即线性链的结构。递归神经网络对任何层次结构进行操作,将子表征结合到父表征中,而递归神经网络对时间的线性进展进行操作,将前一个时间步骤和一个隐藏表征结合到当前时间步骤的表征中。

特别是,RNN可以作为有限脉冲响应和无限脉冲响应滤波器的非线性版本出现,也可以作为非线性自回归外生模型(NARX)。

如果有其他专业的代写需要,如:神经生物学和行为学(Neurobiology and Behavior),电子神经诊断/脑电图(Electroneurodiagnostic/Electroencephalographic),技术(Technology/Technologist), 神经解剖学(Neuroanatomy),神经生物学和解剖学(Neurobiology and Anatomy),神经生物学和神经科学(Neurobiology and Neurosciences),神经药理学(Neuropharmacology),神经科学(Neuroscience),欢迎咨询AcademicPhD!